國際機器學習大會(International Conference on Machine Learning,簡稱ICML)是機器學習領(lǐng)域的頂級會議。ICML 2025計劃于2025年7月13日-7月19日在加拿大溫哥華召開。自動化所多篇研究論文被本屆會議錄用,本文將對相關(guān)成果進行介紹,歡迎交流討論。

1.大模型繼續(xù)預訓練中的學習動態(tài)??★Spotlight

英文標題:Learning Dynamics in Continual Pre-Training for Large Language Models

論文作者:王星錦,Howe Tissue,王露,李林靜,曾大軍

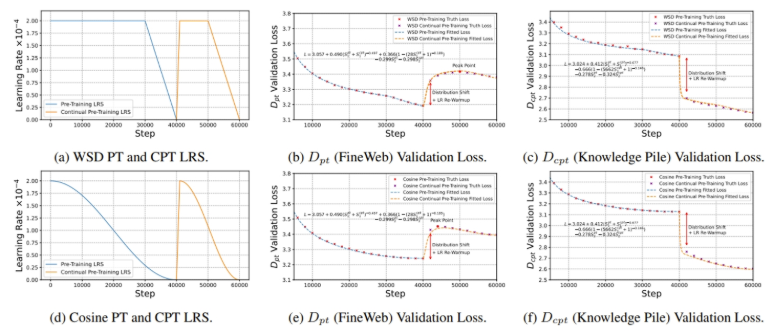

繼續(xù)預訓練(CPT)是將基礎大模型應用于特定下游任務的有效方法。在這項工作中,我們探索了大語言模型在整個CPT過程中的學習動態(tài)。我們關(guān)注在CPT過程中每個訓練步驟下通用領(lǐng)域和下游領(lǐng)域模型性能的動態(tài),并通過相應的測試集損失來衡量性能變化。我們觀察到CPT損失曲線是從一條隱藏的預訓練曲線到另一條隱藏預訓練曲線的轉(zhuǎn)變,并且可以通過解耦數(shù)據(jù)分布轉(zhuǎn)移和學習率退火的影響來描述CPT曲線。我們提出了結(jié)合這兩個因素的CPT Scaling Law 可以預測CPT中任何訓練步驟和學習率調(diào)度的測試集損失。我們的公式展示了對CPT中幾個關(guān)鍵因素的全面理解,包括Loss Potential、最大學習率、訓練量和預訓練數(shù)據(jù)混合比。此外,我們的方法可以為不同的CPT目標定制訓練超參數(shù)來平衡通用領(lǐng)域和下游領(lǐng)域的性能。

圖1.繼續(xù)預訓練過程中的損失曲面和兩個方向的側(cè)視圖。前進方向會導致通用領(lǐng)域測試集損失上升和下游領(lǐng)域測試集損失下降,而學習率退火的方向會導致各個測試集損失的快速下降。

圖2.利用我們提出的CPT Scaling Law對各種學習率調(diào)度的預訓練和繼續(xù)預訓練階段的損失曲線進行預測。

2.基于樹搜索的重排序推理上下文策略以增強大型視覺-語言模型性能???★Spotlight

Re-ranking Reasoning Context with Tree Search Makes Large Vision-Language Models Stronger

論文作者:楊奇,張承灝,樊魯斌,丁昆,葉杰平,向世明

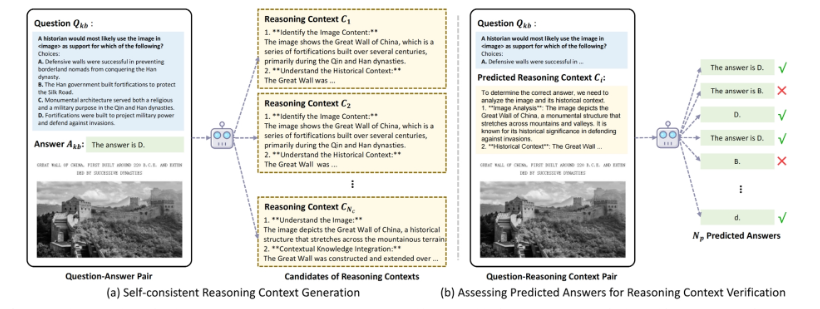

近年來,大型視覺語言模型(LVLMs)結(jié)合檢索增強生成(RAG)技術(shù)在視覺問答(VQA)任務中展現(xiàn)出卓越的性能。然而,現(xiàn)有方法仍面臨兩個關(guān)鍵挑戰(zhàn):一是檢索樣本缺乏包含推理過程的知識,二是檢索到的知識可能和用戶問題不一致導致回答出錯。為解決這些問題,本文提出了一種基于推理上下文與樹搜索的多模態(tài)檢索增強生成框架。

該框架主要包括兩個核心模塊:推理上下文豐富的知識庫構(gòu)建和基于啟發(fā)式獎勵的樹搜索重排序機制。首先,通過自洽評估機制,自動為問答對生成推理上下文,從而豐富知識庫中的邏輯推理模式;其次,采用蒙特卡洛樹搜索(MCTS)結(jié)合啟發(fā)式獎勵策略,對檢索結(jié)果進行重排序,優(yōu)先選擇最相關(guān)的樣例作為上下文輸入。這一方法有效提升了LVLMs在生成答案時的一致性與準確性。

圖1.推理上下文生成的示意圖。該生成方法包含兩個步驟:(a) 利用知識庫中的問題-答案對來生成內(nèi)容自洽的推理上下文。(b) 通過定量評估對預測答案進行驗證,以選擇最優(yōu)的推理上下文。

圖2.基于啟發(fā)式獎勵的蒙特卡洛樹搜索(MCTS-HR)示意圖。為了解決用戶的問題,本文首先檢索出Top-N個候選樣本作為候選動作,隨后通過MCTS-HR方法對這些候選樣本進行重新排序與選擇。此外,本文還提出了一種啟發(fā)式獎勵策略,該策略包含兩個關(guān)鍵組成部分:自洽性啟發(fā)式獎勵和互惠啟發(fā)式獎勵,旨在優(yōu)化MCTS框架中的獎勵函數(shù)。

3.AffectGPT:借助多模態(tài)大模型的描述性情感理解:數(shù)據(jù)集、模型、基線??★Spotlight

AffectGPT: A New Dataset, Model, and Benchmark for Emotion Understanding with Multimodal Large Language Models

論文作者:連政、陳皓宇、陳嵐、孫海洋、孫立才、任勇、程澤浜、劉斌、劉瑞、彭小江、易江燕、陶建華

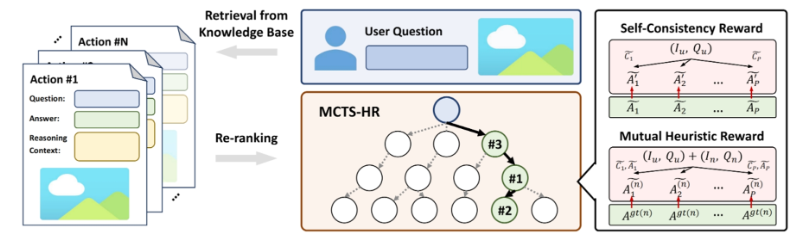

情感蘊含著意圖信息,準確識別情感狀態(tài)對于提升人機交互體驗至關(guān)重要。傳統(tǒng)方法主要依賴于判別式框架,將人類情感映射到預定義情感分類體系中最可能的類別。然而,這種分類框架在模擬人類情感狀態(tài)時存在一定局限性。隨著多模態(tài)大模型(MLLMs)的快速發(fā)展,使得情感理解得以突破傳統(tǒng)判別式框架的局限,轉(zhuǎn)向更具表達力的生成式框架。這一轉(zhuǎn)變使模型能夠通過自然語言描述復雜且共存的情感狀態(tài)。憑借大規(guī)模詞表,MLLMs 能夠生成超越基礎情感的多樣化、細粒度情感類別,為準確的情感理解開辟了新的可能性。然而,最新研究表明,MLLMs 在情感理解方面仍存在諸多局限性:1)缺乏包含描述性情感標注的大規(guī)模數(shù)據(jù)集; 2)缺乏以多模態(tài)為核心的框架來最大化MLLMs的情感理解潛力。針對這些問題,我們構(gòu)建了一個面向生成式情感理解框架的數(shù)據(jù)集(MER-Caption)和模型架構(gòu)(AffectGPT)。借助人類先驗知識引導自動化標注流程,我們構(gòu)建了迄今為止規(guī)模最大的描述性情感數(shù)據(jù)集,包含超過2K個細粒度情感類別和115K個樣本。同時,我們提出了AffectGPT框架,該模型采用預融合操作來增強多模態(tài)信息的整合能力。此外,我們還推出了MER-UniBench,一個統(tǒng)一的評測基準,專門針對典型MER任務和MLLMs的自由形式自然語言輸出特點進行設計。大量實驗結(jié)果表明,AffectGPT在各類MER任務中均展現(xiàn)出強大的性能。

4.Agent Reviewers:具有共享記憶的多模態(tài)領(lǐng)域特定智能體論文評審系統(tǒng)

Agent Reviewers: Domain-speciffc Multimodal Agents?with Shared Memory for Paper Review

論文作者:盧凱,許世雄,李金秋,丁昆,孟高峰

同行評審的反饋對于提升科學文章的質(zhì)量至關(guān)重要。然而,目前許多稿件在提交之前或提交過程中并未獲得足夠的外部反饋來進行完善。因此,一個能夠提供詳細且專業(yè)反饋的系統(tǒng)對于提高研究效率來說至關(guān)重要。在本文中,我們通過收集歷史上的開放獲取論文及其相應的評審意見,并使用大語言模型(LLM)對其進行標準化處理,得到了目前最大的論文評審數(shù)據(jù)集。隨后,我們基于大語言模型開發(fā)了一個多智能體系統(tǒng),該系統(tǒng)模擬了真實的人類評審過程。這個名為 “Agent Reviewers”的系統(tǒng)創(chuàng)新性地引入了多模態(tài)評審員,用于對論文的視覺元素提供反饋。此外,還保留了一個共享記憶池,其中存儲了歷史論文的元數(shù)據(jù),為評審智能體提供了來自不同領(lǐng)域的背景知識。我們使用 2024 年國際學習表征會議(ICLR)的論文對該系統(tǒng)進行了評估,結(jié)果顯示其性能優(yōu)于現(xiàn)有的基于人工智能的評審系統(tǒng)。全面的消融研究進一步證明了該系統(tǒng)中每個模塊和智能體的有效性。

“Agent Reviewers”系統(tǒng)概述。在第一階段,元審稿人從論文文本中提取關(guān)鍵詞,并從共享內(nèi)存池(SMP)中檢索記憶信息,用于初始化特定領(lǐng)域評審員。在第二階段,多模態(tài)審稿人提供論文視覺方面的評論,領(lǐng)域特定審稿人將這些視覺評論與論文文本相結(jié)合進行初步評審,并進行討論以修訂意見。最后,領(lǐng)域主席(AC)整合所有經(jīng)過修訂的評審意見,給出最終評論并做出接收決定,并用論文信息和審稿意見更新共享內(nèi)存池(SMP)。

5.受限可利用度下降:一種求解混合策略納什均衡的離線強化學習方法

Constrained Exploitability Descent: An Offline Reinforcement Learning Method for Finding Mixed-Strategy Nash Equilibrium

論文作者:陸潤宇,朱圓恒,趙冬斌

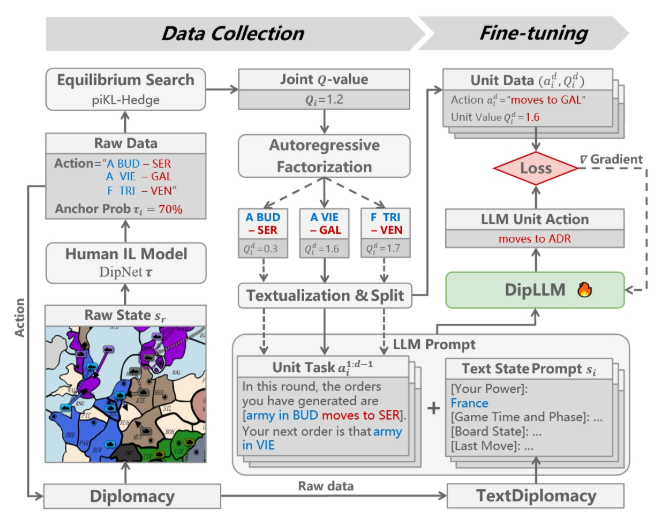

本文提出了受限可利用度下降(CED),一種求解對抗馬爾可夫博弈的無模型離線強化學習算法,將可利用度下降(ED)這種博弈論方法與離線強化學習中的策略約束方法相結(jié)合。策略約束在單智能體場景下會擾動最優(yōu)的純策略解,然而這種擾動對于求解對抗博弈中的混合策略納什均衡未必是有害的。本文理論證明了當數(shù)據(jù)集滿足完全覆蓋條件時,CED能在確定性兩人零和馬爾可夫博弈中收斂到穩(wěn)定點。進一步,本文證明了在穩(wěn)定點處的最小玩家策略具有混合策略納什均衡的不可利用性質(zhì)。相比基于模型且優(yōu)化最大玩家的ED算法,本文提出的CED方法在限制分布偏移的同時不再依賴于廣義梯度。通過矩陣博弈、樹狀博弈和無限時間的足球游戲?qū)嶒烌炞C了CED能夠在完全覆蓋的數(shù)據(jù)集下求解均衡策略,納什誤差顯著低于博弈領(lǐng)域已有的VI-LCB-Game算法。在非完全覆蓋下,CED則能逐漸降低行為克隆(BC)得到的行為策略的可利用度,在大規(guī)模的兩隊3v3機器人對抗博弈中展現(xiàn)出優(yōu)于離線自我博弈(OSP)算法的性能。

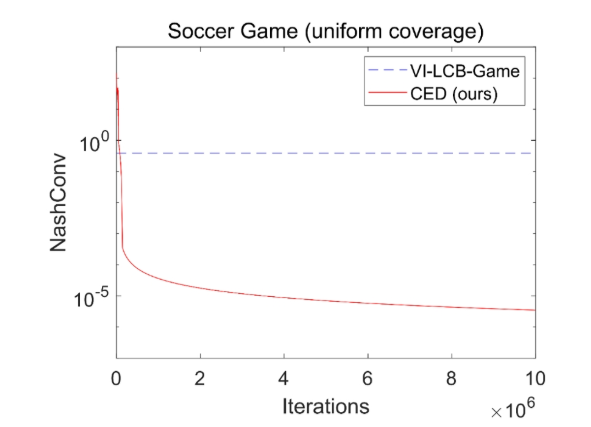

圖1.兩人足球游戲(完全覆蓋數(shù)據(jù)集)下對比基線算法的納什誤差曲線

圖2.兩隊3v3機器人對抗博弈(非完全覆蓋數(shù)據(jù)集)下對戰(zhàn)行為策略的勝率曲線

6.DipLLM:面向強權(quán)外交游戲戰(zhàn)略決策的微調(diào)大語言模型

DipLLM: Fine-Tuning LLM for Strategic Decision-making in Diplomacy

論文作者:徐凱旋,柴嘉駿,李思成,傅宇千,朱圓恒,趙冬斌

強權(quán)外交(Diplomacy)是一款高度復雜的多人博弈游戲,融合了合作與競爭機制,對人工智能系統(tǒng)提出了嚴峻挑戰(zhàn)。傳統(tǒng)方法通常依賴均衡搜索生成大規(guī)模博弈數(shù)據(jù)以訓練模型,但該過程計算成本極高。大語言模型(LLMs)提供了一種具有前景的替代方案,能夠借助預訓練知識,在僅需少量微調(diào)數(shù)據(jù)的前提下實現(xiàn)強大的決策能力。然而,將LLMs應用于強權(quán)外交仍面臨諸多挑戰(zhàn),包括指數(shù)級增長的動作空間和玩家間高度復雜的戰(zhàn)略互動。為此,本文提出DipLLM,一種基于LLM微調(diào)的智能體,旨在高效學習該游戲中的均衡策略。DipLLM 構(gòu)建于自回歸分解框架之上,將多單位指令決策建模為按單位逐步生成的序列任務,并以理論定義的均衡策略為訓練目標。實驗結(jié)果表明,DipLLM 僅使用Cicero(Science,2022)所需數(shù)據(jù)量的1.5%進行微調(diào),便實現(xiàn)了2.2%的性能提升,驗證了微調(diào)后的LLMs在復雜多人博弈中的戰(zhàn)略決策潛力。

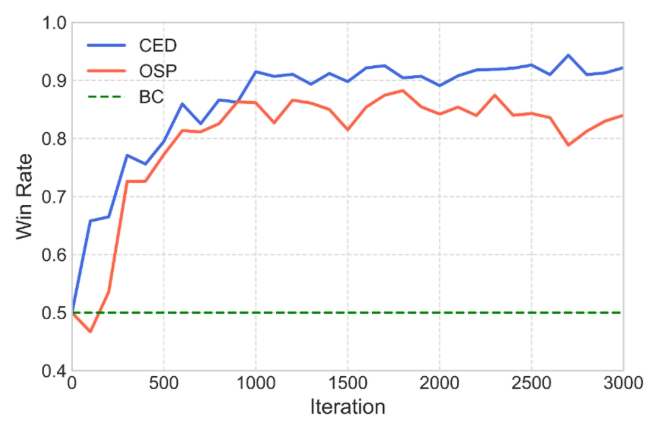

圖1.基于大語言模型的自回歸分解智能體的推理流程圖

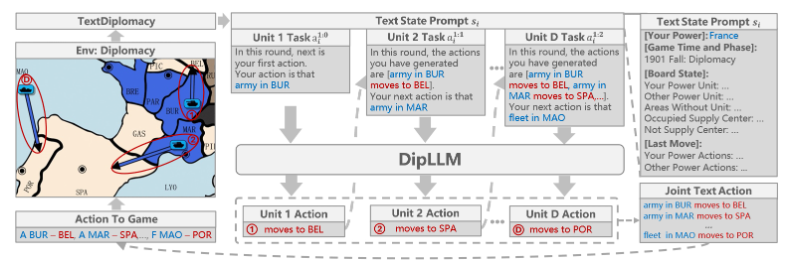

圖2.基于大語言模型的自回歸分解智能體的微調(diào)流程圖

7.重新思考聯(lián)邦異質(zhì)蒸餾的溫度

Rethinking the Temperature for Federated Heterogeneous Distillation

論文作者:亓帆,史大旭,徐踔錕,李帥,徐常勝

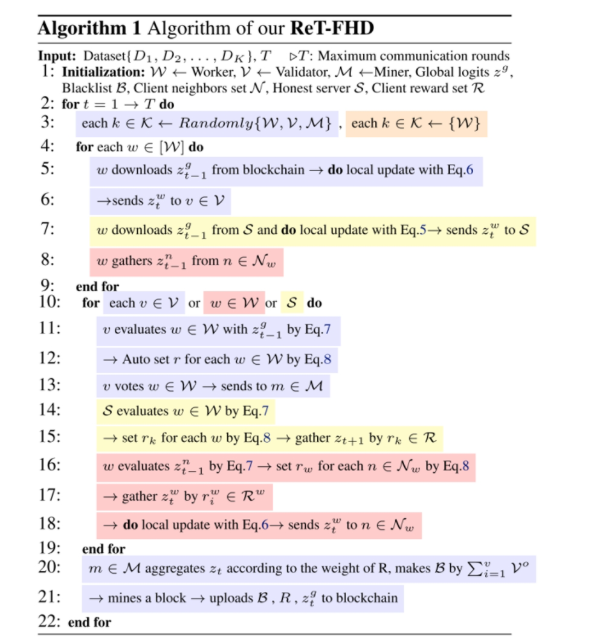

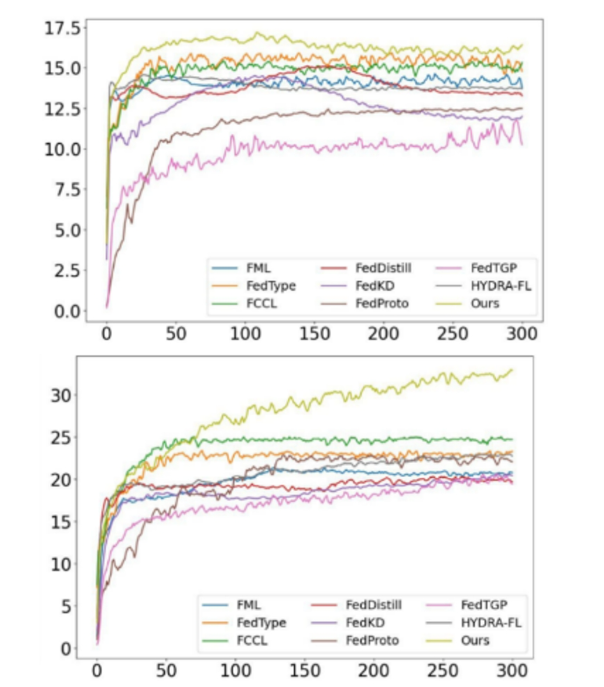

聯(lián)邦異質(zhì)蒸餾是應對聯(lián)邦學習中模型與數(shù)據(jù)異構(gòu)性挑戰(zhàn)的一種有效的優(yōu)化框架。然而,雖然近期的研究提出了一些額外的知識載體來進一步緩解模型異構(gòu)問題,但是都不可避免地引入了安全風險和顯著的計算與通信開銷。因此僅使用最小知識載體——logits,在無需公共數(shù)據(jù)集或額外信息的前提下,能否有效應對聯(lián)邦學習中的異構(gòu)問題成為了亟待探索的關(guān)鍵問題。

我們提出了ReT-FHD框架,從理論與實證的角度重新審視蒸餾溫度問題。該框架引入多層彈性溫度機制,實現(xiàn)模型各層間蒸餾強度的動態(tài)調(diào)節(jié),同時采用類別感知全局溫度縮放策略,根據(jù)本地各類別的性能差異為每個類別自適應分配溫度,實現(xiàn)更加個性化的知識蒸餾。此外,該框架還集成了Z-Score驗證機制,降低標簽翻轉(zhuǎn)和模型投毒攻擊帶來的性能下降風險。

實驗表明,ReT-FHD在無需依賴額外信息的情況下,能夠在中心化、去中心化及基于區(qū)塊鏈的聯(lián)邦學習場景中有效提升模型性能,同時規(guī)避安全風險,并顯著降低計算與通信開銷。

圖1.算法偽代碼

圖2.在TinyImageNet(上)、Flower102(下)上測試的Dir(0.1)分布的準確率曲線。

8.基于保局馬爾可夫狀態(tài)轉(zhuǎn)移的實例檢索

Locality Preserving Markovian Transition for Instance Retrieval

論文作者:駱霽飛,吳汶政,姚涵濤,余璐,徐常勝

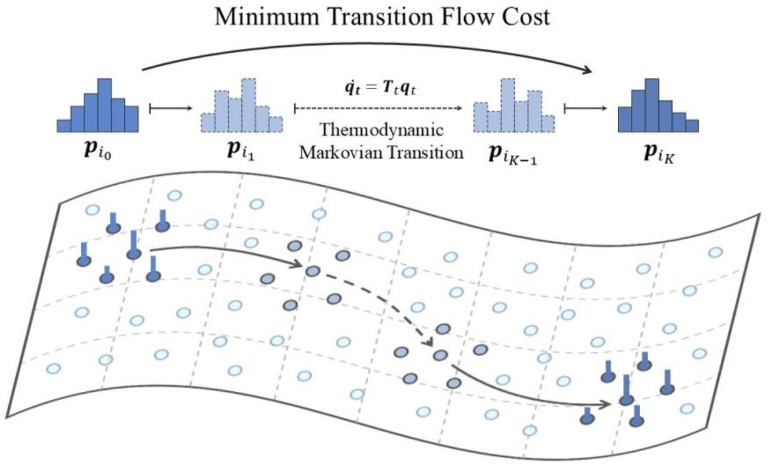

實例檢索(Instance Retrieval)是計算機視覺領(lǐng)域的一項核心任務,其旨在從大規(guī)模圖像數(shù)據(jù)庫中快速準確地找到與給定查詢圖像相似的所有圖像。為了進一步提升檢索精度,尤其是彌補初步檢索可能存在的誤差,重排序(Re-ranking)技術(shù)應運而生,它通常通過分析初步檢索結(jié)果中圖像間的關(guān)系來優(yōu)化排序結(jié)果。

其中,基于擴散的重排序方法因其能夠有效地利用數(shù)據(jù)樣本間的相似性關(guān)系,通過在近鄰圖上進行信息傳播,從而更好地建模數(shù)據(jù)流形(data manifolds)結(jié)構(gòu),展現(xiàn)出良好的性能。然而,這類方法存在一個關(guān)鍵問題:當相似度信號在圖上進行多步傳播時,距離源點較遠的樣本其信號會迅速衰減。這意味著傳統(tǒng)擴散方法難以有效地捕捉和利用全局范圍內(nèi)的相似性信息,尤其是在局部區(qū)域之外,判別能力會顯著下降,限制了其在大規(guī)模檢索中的表現(xiàn)。

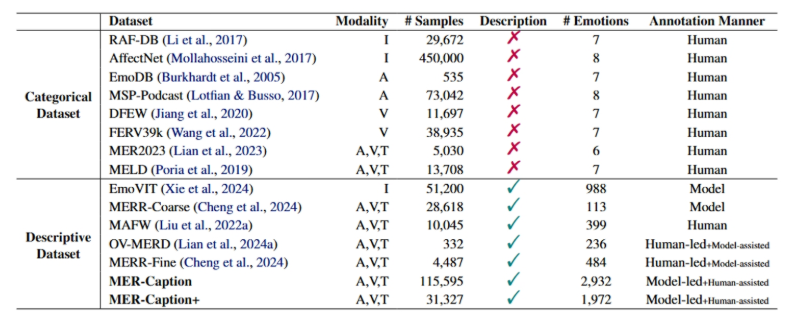

為了克服這一局限性,我們提出了一個全新的保局馬爾可夫轉(zhuǎn)移(Locality Preserving Markovian Transition, LPMT)框架,該框架借助一個具有多個狀態(tài)的長程熱力學轉(zhuǎn)移過程,實現(xiàn)了更精確的流形距離測量。具體來說, LPMT首先利用雙向協(xié)作擴散(Bidirectional Collaborative Diffusion, BCD)整合不同圖上的擴散過程,以此更好地估計相似度關(guān)系。隨后,局部狀態(tài)嵌入(Locality State Embedding, LSE)將每個實例編碼為一個分布,以增強局部一致性。這些分布通過熱力學馬爾可夫轉(zhuǎn)移(Thermodynamic Markovian Transition, TMT)過程相互連接,從而在保持局部有效性的同時,實現(xiàn)高效的全局檢索。

圖1.保局馬爾可夫狀態(tài)轉(zhuǎn)移過程示意圖

9.時相關(guān)性對齊

Test-time Correlation Alignment

論文作者:游琳敬,祿家寶,黃夏淵

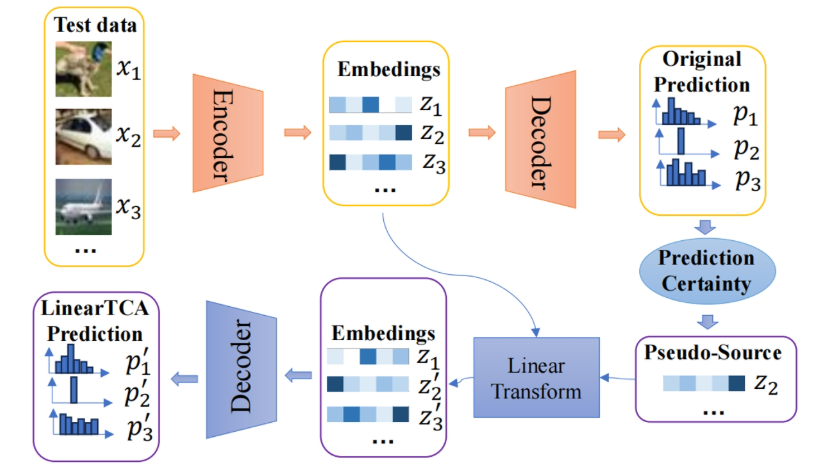

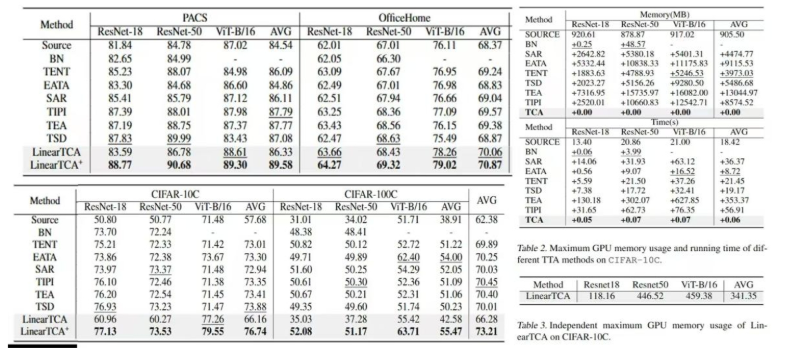

深度神經(jīng)網(wǎng)絡常因訓練數(shù)據(jù)與測試數(shù)據(jù)間的分布偏移而出現(xiàn)顯著的性能下降。盡管領(lǐng)域自適應(Domain Adaptation)能在一定程度上解決該問題,但現(xiàn)實場景中的隱私問題往往限制了其對訓練數(shù)據(jù)的訪問。這一限制催生了測試時自適應(Test-Time Adaptation, TTA)的研究,TTA僅需利用未標注的測試數(shù)據(jù)來調(diào)整預訓練模型。然而現(xiàn)有TTA研究仍面臨三大挑戰(zhàn):(1)主要關(guān)注實例級對齊,因缺失源域相關(guān)性而忽視了相關(guān)性對齊(CORrelation ALignment, CORAL);(2)依賴復雜的反向傳播機制更新模型,計算開銷過大;(3)存在域遺忘問題。

為應對這些挑戰(zhàn),本文首先通過理論分析驗證了測試時相關(guān)性對齊(Test-time Correlation Alignment, TCA)的可行性,證明高置信度樣本與測試樣本間的相關(guān)性對齊可有效提升模型性能。基于此,本文提出兩種簡潔且高效的算法:LinearTCA與LinearTCA+。前者通過簡單線性變換同時實現(xiàn)實例對齊與相關(guān)性對齊,無需額外模型更新;后者作為即插即用模塊,可輕松增強現(xiàn)有TTA方法。大量實驗證明了我們的理論和算法的有效性,實驗結(jié)果表明TCA在各類任務、數(shù)據(jù)集和骨干網(wǎng)絡中均顯著優(yōu)于基線。

圖1.模型框架。LinearTCA算法的具體流程如下:在測試階段,首先通源模型獲取目標數(shù)據(jù)的原始嵌入特征和預測結(jié)果。根據(jù)原始預測結(jié)果篩選高置信度嵌入特征,構(gòu)建"偽源域"。隨后施加線性變換,將原始嵌入特征的相關(guān)性與偽源域進行對齊,最終輸出LinearTCA的預測結(jié)果。值得注意的是,該過程無需更新原始模型的任何參數(shù)。

圖2.實驗結(jié)果。TCA方法在多種數(shù)據(jù)集、多種網(wǎng)絡架構(gòu)下模型預測準確率、運行時間、最大GPU內(nèi)存占用的具體性能表現(xiàn)結(jié)果。

10.基于擴散策略的最大熵強化學習算法

Maximum Entropy Reinforcement Learning with Diffusion Policy

論文作者:董曉藝,程健,張希

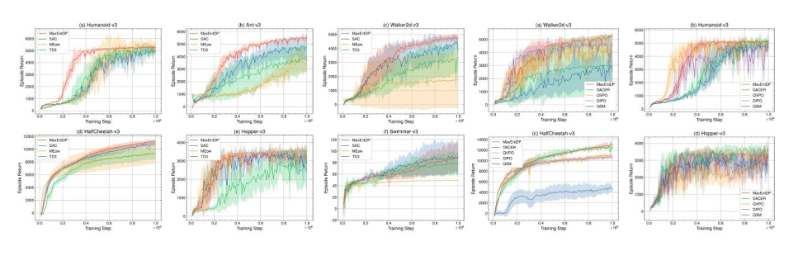

最大熵強化學習將策略熵加入強化學習的目標函數(shù)中,來提高智能體的探索能力并增強所學策略的魯棒性。目前,使用高斯策略的Soft Actor-Critic(SAC)算法已成為實現(xiàn)最大熵強化學習目標的主流算法。盡管高斯策略在簡單任務中表現(xiàn)良好,但在復雜的多目標強化學習環(huán)境中,其固有的單峰性會限制SAC算法的探索能力和潛在性能。由于擴散模型能夠擬合復雜的多峰分布,因此本文在SAC算法中引入擴散模型作為策略表示,提出了一種基于擴散策略的最大熵強化學習算法MaxEntDP,可以實現(xiàn)高效探索,并使策略更接近最大熵強化學習目標下的最優(yōu)策略。MaxEntDP算法的訓練過程涉及兩個關(guān)鍵步驟:擬合Q函數(shù)的指數(shù)分布以及計算擴散策略的對數(shù)概率,這對于擴散模型而言并非易事。為了解決這兩個挑戰(zhàn),我們提出了一種Q加權(quán)噪聲估計(Q-weighted Noise Estimation)方法來訓練擴散策略,同時引入一種數(shù)值積分方法來近似計算擴散模型的對數(shù)概率。在Mujoco基準測試上的實驗結(jié)果表明,MaxEntDP在最大熵強化學習框架下優(yōu)于高斯策略和其他生成模型,并且性能與現(xiàn)有基于擴散模型的在線強化學習算法相當。

11.離線對手建模算法改進框架:截斷Q驅(qū)動的即時策略精煉

Offline Opponent Modeling with Truncated Q-driven Instant Policy Refinement

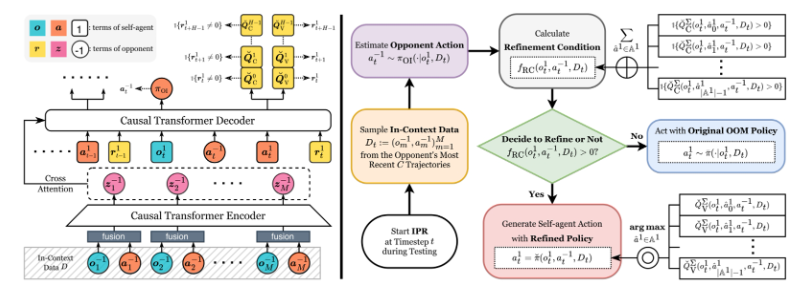

論文作者:景煜恒,李凱,劉秉運,張紫聞,傅浩波,付強,興軍亮,程健

離線對手建模(OOM)旨在使用來自多智能體博弈的離線數(shù)據(jù)集,學習一種能夠動態(tài)適應對手的自適應自主智能體策略。先前的工作假設數(shù)據(jù)集是最優(yōu)的。然而,這個假設在現(xiàn)實世界中難以滿足。當數(shù)據(jù)集是次優(yōu)的時,現(xiàn)有方法難以有效工作。為了解決這個問題,我們提出了一個簡單且通用的算法改進框架,即由截斷Q驅(qū)動的即時策略精煉(TIPR),以處理由數(shù)據(jù)集引發(fā)的OOM算法的次優(yōu)性問題。TIPR框架本質(zhì)上是即插即用的。與原始的OOM算法相比,它僅需要兩個額外的步驟:(1)使用離線數(shù)據(jù)集學習一個時域截斷的、基于上下文的動作價值函數(shù),即截斷Q(Truncated Q)。截斷Q估計在一個固定的、截斷的時域內(nèi)的期望回報,并且以對手信息為條件。(2)在測試期間,使用學習到的截斷Q來即時決定是否執(zhí)行策略精煉,并在精煉后生成策略。理論上,我們從無最大化偏差概率的角度分析了截斷Q的原理。實驗上,我們在四個代表性的競爭環(huán)境中進行了廣泛的比較實驗和消融實驗。TIPR有效地改進了多種使用次優(yōu)數(shù)據(jù)集預訓練的OOM算法。

12.基于目標導向技能抽象的離線多任務強化學習

Goal-Oriented Skill Abstraction for Offline Multi-Task Reinforcement Learning

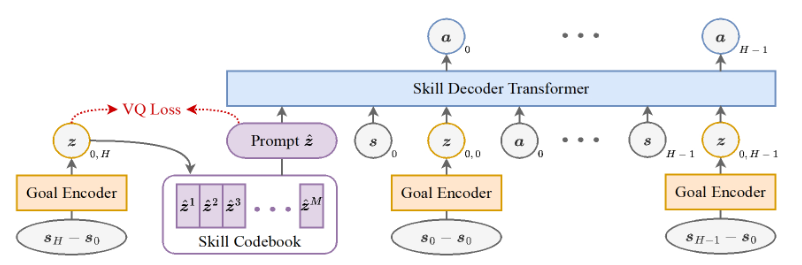

論文作者:何金珉,李凱,臧一凡,傅浩波,付強,興軍亮,程健

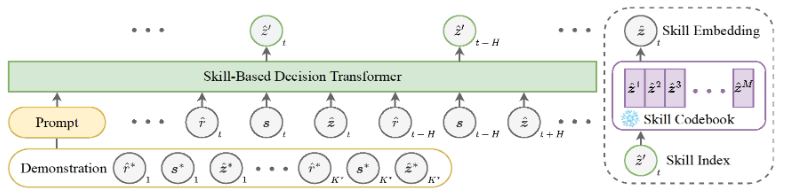

離線多任務強化學習旨在利用預先收集的數(shù)據(jù)集學習一個統(tǒng)一的策略,以在無需與環(huán)境進行任何在線交互的情況下解決多個任務。然而,該領(lǐng)域在跨任務有效共享知識方面面臨巨大挑戰(zhàn)。受人類學習中高效知識抽象機制的啟發(fā),我們提出了一種新方法——面向目標的技能抽象GO-Skill,旨在提取和利用可復用技能,以提升離線多任務強化學習中的知識遷移能力和任務表現(xiàn)。我們的方法通過目標導向的技能提取過程挖掘可復用技能,并利用向量量化構(gòu)建離散技能庫。為緩解廣泛適用技能與任務特定技能之間的類別不平衡問題,我們引入了一個技能增強階段,對提取出的技能進行優(yōu)化。此外,我們通過分層策略學習將這些技能整合起來,從而構(gòu)建出一個高層策略,能夠動態(tài)組合離散技能以完成特定任務。在MetaWorld基準平臺的多種機器人操作任務中進行的大量實驗表明,GO-Skill在有效性和通用性方面都具有顯著優(yōu)勢。

圖1.?GO-Skill目標導向的技能模型

圖2.GO-Skill基于技能的策略模型?

13.CSTrack: 通過緊湊時空建模來增強RGB-X跟蹤

CSTrack: Enhancing RGB-X Tracking via Compact Spatiotemporal Features

論文作者:豐效坤,張岱凌,胡世宇,李旭晨,武美奇,張靖,陳曉棠,黃凱奇

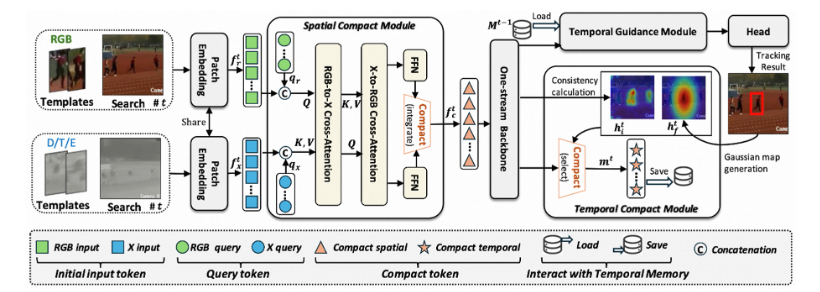

有效建模和利用來自RGB及其他模態(tài)(例如,深度、熱成像和事件數(shù)據(jù),簡稱為X)的時空特征是RGB-X追蹤器設計的核心。現(xiàn)有方法通常采用兩個平行分支分別處理RGB和X輸入流,這要求模型同時處理兩個分散的特征空間,復雜化了模型結(jié)構(gòu)和計算過程。更為關(guān)鍵的是,每個分散空間內(nèi)模態(tài)內(nèi)的空間建模會產(chǎn)生較大的計算開銷,限制了用于模態(tài)間空間建模和時間建模的資源。為了解決這一問題,我們提出了一種新的追蹤器,CSTrack,其重點是建模緊湊的時空特征,以實現(xiàn)簡單而有效的追蹤。具體來說,我們首先引入了一個創(chuàng)新的空間緊湊模塊,將RGB-X雙輸入流整合為緊湊的空間特征,從而實現(xiàn)徹底的模態(tài)內(nèi)和模態(tài)間空間建模。此外,我們設計了一個高效的時序緊湊模塊,通過構(gòu)建優(yōu)化的目標分布熱圖緊湊地表示時間特征。廣泛的實驗驗證了我們緊湊時空建模方法的有效性,CSTrack在7個主流RGB-X基準上取得了新的SOTA結(jié)果。

CSTrack的模型框架。對于時間t時刻的RGB和X(例如熱成像數(shù)據(jù))輸入流,通用的嵌入模塊最初將它們轉(zhuǎn)換為token序列。然后,空間緊湊模塊將它們整合為一個緊湊的特征空間,該特征空間隨即被輸入到單流骨干網(wǎng)絡中進行全面的空間建模。接下來,時間指導模塊利用之前存儲的時間特征進行追蹤指導,隨后跟蹤頭生成最終的追蹤結(jié)果。之后,時間緊湊模塊為當前時間步構(gòu)建緊湊的時間特征,這些特征被存儲以便在下一時間步t + 1進行追蹤引導。

14.基于雙層優(yōu)化的大語言模型數(shù)據(jù)選擇與利用

LLM Data Selection and Utilization via Dynamic Bi-level Optimization

論文作者:于楊,韓凱,周航,唐業(yè)輝,黃凱奇,王云鶴,陶大程

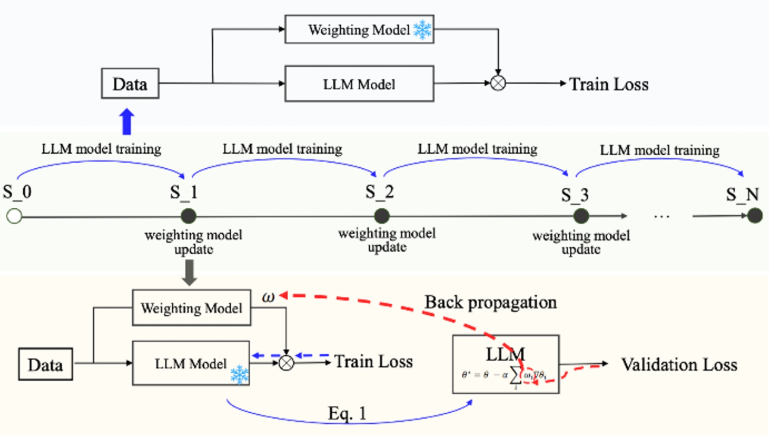

盡管大規(guī)模訓練數(shù)據(jù)是構(gòu)建高性能大型語言模型(LLM)的基礎,但如何戰(zhàn)略性地篩選高質(zhì)量數(shù)據(jù),已成為提升訓練效率與降低計算成本的關(guān)鍵途徑。現(xiàn)有數(shù)據(jù)選擇方法主要依賴靜態(tài)、與訓練過程無關(guān)的標準,難以反映模型在訓練過程中對數(shù)據(jù)的動態(tài)需求。為此,本文提出一種新的數(shù)據(jù)加權(quán)模型(DWM),用于動態(tài)調(diào)整每一批次訓練數(shù)據(jù)的權(quán)重,從而實現(xiàn)訓練過程中更有效的數(shù)據(jù)利用。為更精準地捕捉模型的動態(tài)數(shù)據(jù)偏好,DWM采用雙層優(yōu)化框架進行更新。實驗結(jié)果表明,DWM不僅提升了相較于隨機數(shù)據(jù)選擇所訓練模型的性能,且其所學習的加權(quán)策略具有良好的遷移能力,可推廣至其他數(shù)據(jù)選擇方法及不同規(guī)模模型中。進一步分析還揭示了模型在訓練過程中數(shù)據(jù)偏好的演化規(guī)律,為理解LLM的數(shù)據(jù)利用機制提供了新的視角。

基于DWM的雙層優(yōu)化框架,其中LLM模型和加權(quán)模型交替訓練

15.從概率神經(jīng)-行為表征對齊中涌現(xiàn)的神經(jīng)表征一致性

Neural Representational Consistency Emerges from Probabilistic Neural-Behavioral Representation Alignment

論文作者:朱宇,宋純鋒,歐陽萬里,余山,黃鐵軍

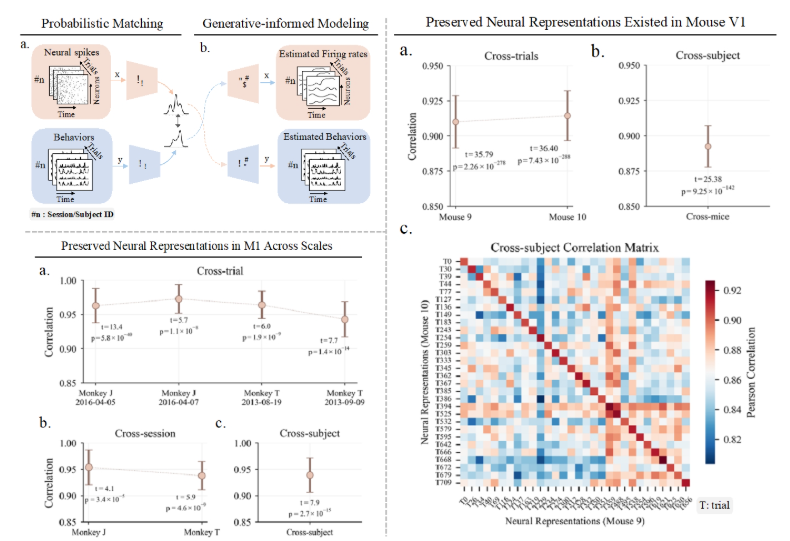

大腦在不同個體間存在顯著的結(jié)構(gòu)和生理差異,卻能產(chǎn)生高度一致的功能特性,這一悖論在神經(jīng)科學領(lǐng)域尚未得到充分探索。雖然近期研究已通過手動對齊方法觀察到運動皮層中跨個體的神經(jīng)表征保留現(xiàn)象,但對這種保留特性的零樣本驗證及其在多種皮層區(qū)域中的普適性仍有待深入研究。本研究提出了概率神經(jīng)-行為表示對齊(PNBA)框架,該框架采用概率模型處理不同試驗、實驗時段和個體間的層次性差異,并通過生成性約束防止表示退化。PNBA通過建立穩(wěn)健的跨模態(tài)表示對齊,成功地通過零樣本驗證揭示了猴子初級運動皮層(M1)和背側(cè)預運動皮層(PMd)中穩(wěn)定保留的神經(jīng)表示模式。我們還將研究擴展至小鼠初級視覺皮層(V1),證實了類似的表征保留現(xiàn)象,表明這可能是一種普遍的神經(jīng)組織原則。這些發(fā)現(xiàn)通過建立零樣本預測范式有效解決了神經(jīng)異質(zhì)性悖論,實現(xiàn)了跨腦區(qū)和跨物種的神經(jīng)表征遷移,不僅深化了對神經(jīng)編碼機制的理解,還為零樣本行為解碼提供了新的方法論基礎。

PNBA方法及其在不同物種皮層中揭示的保留神經(jīng)表征。左上:PNBA方法框架。(a) 通過概率匹配策略對神經(jīng)活動與行為表征進行對齊,有效處理不同個體間的神經(jīng)異質(zhì)性。(b) 生成性約束建模確保表征穩(wěn)定性,防止退化現(xiàn)象。左下:猴子運動皮層(M1)中跨尺度的保留神經(jīng)表征。(a) 神經(jīng)元活動模式在不同個體間存在共性特征。(b-c) 零樣本驗證結(jié)果表明,盡管存在神經(jīng)異質(zhì)性,單一共享網(wǎng)絡仍能在新個體上準確預測行為,證實了M1中神經(jīng)編碼的跨個體保留特性。右側(cè):小鼠初級視覺皮層(V1)中發(fā)現(xiàn)的保留神經(jīng)表征。(a) V1中神經(jīng)活動序列的跨個體共性特征。(b) 不同視覺刺激誘發(fā)的神經(jīng)響應保留模式。(c) 零樣本遷移結(jié)果顯示V1表征在不同個體間的一致性,支持神經(jīng)編碼保留現(xiàn)象的普適性。

16.MM-RLHF:多模態(tài)大模型對齊的新里程碑

MM-RLHF: The Next Step Forward in Multimodal LLM Alignment

論文作者:張一帆,于濤,田浩辰,傅超友,李沛言,曾建樹,謝武林,史陽,張桓瑜,吳俊康,王雪,胡一博,文彬,楊帆,張彰,高婷婷,張迪,王亮,金榕,譚鐵牛

盡管多模態(tài)大語言模型(MLLMs)取得了顯著的進展,但現(xiàn)有的先進模型仍然缺乏與人類偏好的充分對齊。這一差距的存在主要是因為現(xiàn)有的對齊研究多集中于某些特定領(lǐng)域(例如減少幻覺問題),是否與人類偏好對齊可以全面提升MLLM的各種能力仍是一個未知數(shù)。

本文從三個層面入手推動MLLM alignment的發(fā)展,包括數(shù)據(jù)集,獎勵模型以及訓練算法,最終的alignment pipeline使得不同基礎模型在10個評估維度,27個benchmark上都取得了一致的性能增益,比較突出的是,基于本文提出的數(shù)據(jù)集和對齊算法對LLaVA-ov-7B模型進行微調(diào)后, conversational 能力平均提升了 19.5%,安全性平均提升了 60%, 而且沒有觀察到安全性和基礎性能之間的tradeoff。

17.自適應中值平滑:在推理階段對遺忘后文生圖擴散模型的對抗防御

Adaptive Median Smoothing: Adversarial Defense for Unlearned Text-to-Image Diffusion Models at Inference Time

論文作者:韓曉軒,楊嵩林,王偉,李洋,董晶

文生圖擴散模型引發(fā)了關(guān)于生成不當內(nèi)容(如色情暴力)的擔憂,盡管已有工作嘗試通過機器遺忘技術(shù)來擦除模型中的不良概念,這些遺忘后模型仍然容易受到對抗性輸入的攻擊,進而重新生成不良內(nèi)容。為保護遺忘后模型,我們提出了一種新穎的推理階段防御策略,用以緩解對抗性輸入的影響。具體而言,我們首先將確保遺忘后擴散模型魯棒性的挑戰(zhàn)建模為一個魯棒回歸問題。在原始的中值平滑方法基礎上,我們提出了使用各向異性噪聲的廣義中值平滑框架,為模型的對抗魯棒性提供了理論保證。基于該框架,我們引入了一種基于詞元自適應調(diào)整的中值平滑方法,能夠根據(jù)每個詞元與不良概念的相關(guān)程度動態(tài)調(diào)整噪聲強度。此外,為提升推理效率,我們在文本編碼階段實現(xiàn)了該自適應方法。實驗表明,我們的方法有效提升了遺忘后模型的對抗魯棒性,同時保持了模型效用和推理效率。

自適應中值平滑流程圖

18.基于少樣本學習實現(xiàn)AI生成圖像跨域檢測泛化

Few-Shot Learner Generalizes Across AI-Generated Image Detection

論文作者:吳詩雨,劉靜,李晶,王業(yè)全

圖像生成模型的快速發(fā)展使得AI合成圖像達到前所未有的逼真程度。盡管這項技術(shù)為創(chuàng)作者提供了便利,但其濫用已嚴重威脅數(shù)字內(nèi)容的可信性。當前檢測方法面臨兩大核心挑戰(zhàn):一是檢測器對未知生成模型圖像的泛化能力不足,難以適應持續(xù)迭代的生成技術(shù)發(fā)展。二是閉源模型訓練數(shù)據(jù)的獲取存在顯著成本壁壘。多數(shù)方案依賴大規(guī)模訓練數(shù)據(jù)的支持,在少樣本應用場景中易出現(xiàn)過擬合現(xiàn)象,難以滿足實際應用中快速響應新型生成模型的技術(shù)需求。

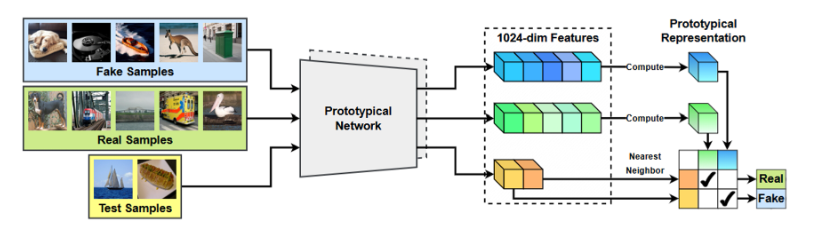

針對上述挑戰(zhàn),本文首次將AI生成圖像檢測重構(gòu)為小樣本分類任務。論文提出基于原型網(wǎng)絡構(gòu)建度量空間,利用給定的少量樣本計算合成圖像的原型表征,通過與待測圖片表征差異的比較,實現(xiàn)合成圖像檢測的跨域泛化。實驗表明,論文提出的圖像檢測框架具有良好的泛化性和適應性,在主流基準測試上取得了新的突破。該方法通過構(gòu)建動態(tài)適配機制,可快速兼容新興生成模型,為應對持續(xù)演進的圖像深度偽造技術(shù)提供有效解決方案。

基于原型網(wǎng)絡的AI合成圖片檢測框架

19.EmoGrowth:基于可增廣情緒關(guān)系圖的多標簽類增量情緒解碼

EmoGrowth: Incremental Multi-label Emotion Decoding with Augmented Emotional Relation Graph

論文作者:付鎧城,杜長德,彭杰,王坤鵬,趙雙辰,陳曉宇,何暉光

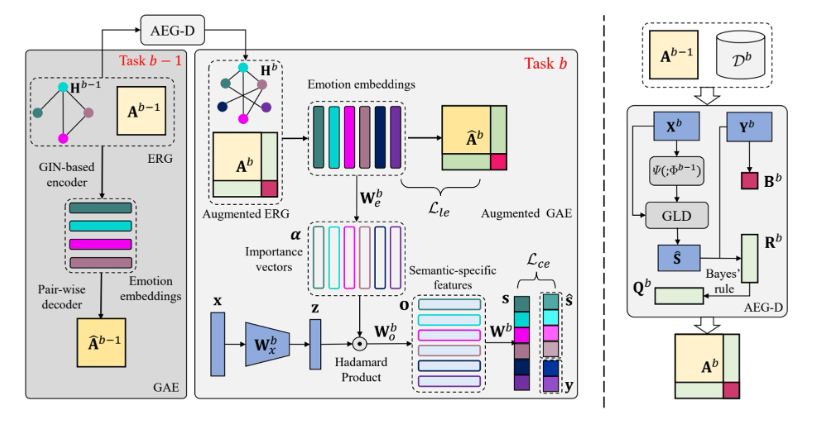

情緒解碼算法在人機交互系統(tǒng)中扮演著重要角色。然而,現(xiàn)有的情緒解碼算法忽略了現(xiàn)實世界中的動態(tài)場景,即人類感受到的復雜多樣的情緒需要增量地整合到模型中,產(chǎn)生了多標簽類增量情緒解碼問題。已有的模型受限于由過去和未來部分標簽缺失造成的災難性遺忘以及未充分挖掘標簽的語義信息,難以解決多標簽類增量學習問題。由此,本文提出一個可增廣的情緒語義學習框架。具體地,設計了一個帶有標簽消歧的可增廣情緒關(guān)系圖模塊,用于處理過去部分標簽缺失問題。接著,利用來自情感維度空間的領(lǐng)域知識,通過基于樣本關(guān)系的知識蒸餾緩解未來部分標簽缺失問題。此外,研究中設計了一個由圖自編碼器構(gòu)成的情緒語義學習模塊,用于獲取情緒語義標簽嵌入,并用于指導語義特定的特征解耦,用以更好地進行多標簽學習。

20.OV-MER:開放詞匯多模態(tài)情感識別

OV-MER: Towards Open-Vocabulary Multimodal Emotion Recognition

論文作者:連政、孫海洋、孫立才、陳皓宇、陳嵐、顧浩、溫卓凡、陳順、張思源、姚海亮、劉斌、劉瑞、梁山、李雅、易江燕、陶建華

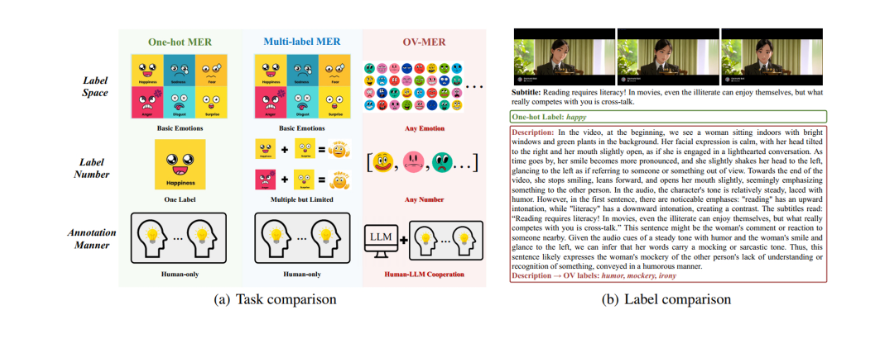

多模態(tài)情感理解(MER)是一個重要的研究方向,旨在從多模態(tài)數(shù)據(jù)中解碼出人類情感狀態(tài),能夠應用于人機交互、智慧健康、智能教育等場景。然而,現(xiàn)有機器學習方法大多依賴于預設的情感分類體系,這些體系往往將人類復雜細微的情感狀態(tài)映射到固定且有限的情感類別,無法捕捉心理學和認知科學研究中所揭示的人類情感所固有的復雜性、微妙性、多維性。為突破這一限制,我們主張將“開放詞匯”概念引入MER領(lǐng)域,這一范式轉(zhuǎn)變旨在使模型能夠預測任意情感類別,從而更準確地刻畫人物情感狀態(tài)。我們將該任務稱為開放詞匯多模態(tài)情感識別(OV-MER),使情感預測不再受限于預定義標簽空間。然而,這種MER范式的轉(zhuǎn)變使得傳統(tǒng)判別式方法不再適用于新的任務。針對這一問題,我們提出了相應的解決方案,包括新的數(shù)據(jù)集構(gòu)建策略、新的評估指標、以及新的解決方案。通過將MER從基本情感識別推進到細粒度情感識別,我們希望這項工作能夠啟發(fā)下一代MER技術(shù)發(fā)展,增強其在現(xiàn)實場景中的應用。

來源:中國科學院自動化研究所

資訊頻道

資訊頻道